Intro

Technisches SEO (eng. technical SEO) ist, wie Onpage- und Offpage-SEO, ein Teilbereich der Suchmaschinenoptimierung. Durch die technische Optimierung einer Webseite wird sichergestellt, dass Inhalte von Suchmaschinen zuverlässig erfasst und verarbeitet werden können.

Somit kann technisches SEO auch als Voraussetzung dafür verstanden werden, dass hochwertig produzierter Content von Suchmaschinen überhaupt gecrawlt bzw. indexiert werden und gute Rankings erreichen kann.

Neben grundlegenden Themen wie Crawling und Indexierung, sind aber auch Server-Probleme, Quellcode, Sicherheit, Ladegeschwindigkeit und Rendering wichtige Aspekte im technischen SEO.

Wie Du diese und noch weitere technische Herausforderung im SEO meisterst, erklären wir Dir in diesem Artikel.

Crawling & Indexierung von Webseiten

Der Crawling- und Indexierungsprozess beschreibt die Identifizierung öffentlich zugänglicher Webseiten und die Aufnahme dieser Webseiten in den Index der Suchmaschine. Dahinter steht eine spezielle Software, die diesen Prozess unterstützt. In der Suchmaschinenoptimierung ist Crawling und die Indexierung essentieller Bestandteil, denn nur dadurch erscheint eine Webseite auf den Sucheregbnissseiten der Suchmaschinen. Es ist also sehr wichtig, dass sowohl der Crawl einer Webseite als auch die Indexierung reibungslos funktioniert, um ihr die Möglichkeit zu geben zu ranken. Für Webseitenbetreiber sollte die effiziente Crawling-Steuerung im Aufbau der Webseite bedacht werden, damit alle relevanten Inhalte sowohl crawl- als auch indexierbar sind und das Crawl-Budget ausschöpfen zu können. In unserem morefire Blogartikel Crawling und Indexierung von Webseiten: Theorie und Praxis erfährst Du nicht nur, was es mit Crawling und der Indexierung auf sich hat, sondern auch wie sich das Crawling steuern und damit die Indexierung beeinflussen lässt und wie Du herausfindest, ob Deine Webseite indexiert ist.

Was bedeutet AMP (Accelerated Mobile Pages)?

Durch die Zunahme des mobilen Traffics wird das Thema Ladezeit immer wichtiger. Langsame Internetseiten können dazu führen, dass Nutzer den Seitenbesuch abbrechen, bevor eine Seite vollständig geladen wurde. Dazu kommt, dass ein hoher Datenverbrauch auf Mobilgeräten immer noch vergleichsweise teuer ist. Accelerated Mobile Pages bestehen teilweise aus klassischen HTML-Elementen, teilweise gibt es aber auch eigene Elementtypen, alles zusammen so konzipiert, dass die Seiten möglichst schnell auf mobilen Endgeräten dargestellt werden können. Die Auszeichnung von AMP-Seiten ist vergleichsweise einfach, für CMS Systeme wie WordPress gibt es sogar Plugins die normale HTML-Seiten in AMP umwandeln. Neben der korrekten Seitenauszeichnung ist auch die Verknüpfung von HTML- und AMP-Seite (und umgekehrt) wichtig, damit die AMP-Seite überhaupt indexiert werden kann. Für fertige AMP-Seiten gibt es einen AMP Validator von Google, mit dessen Hilfe Du die Seiten auf Fehler überprüfen kannst, Hinweise kriegt Du aber auch über die Google Search Console. Weitere Informationen zum Thema AMP erhältst Du in unserem sehr umfangreichen Blogartikel zum Thema AMP.

Was sind HTTP-Statuscodes und welche gibt es?

Die dreistelligen HTTP-Statuscodes spielen nicht nur in der Webentwicklung eine wichtige Rolle, auch als SEO musst Du diese im Blick behalten, um Webseiten ganzheitlich optimieren zu können. Die fünf Statusklassen lassen sich anhand ihrer Bedeutung und Funktion unterscheiden, wobei immer die erste Ziffer des Statuscodes die Klasse bestimmt. Es gibt diverse HTTP-Statuscodes, allerdings sind einige davon besonders wichtig in der Suchmaschinenoptimierung. Dazu gehören Codes der Statusklasse 3xx (301, 302, 307, 308), 4xx (401,403, 404, 410) und 5xx (500, 503), aber auch der Statuscode 200. Wo diese Codes entstehen, welche Du Dir genauer anschauen solltest und wie Du sie überprüfst, das erfährst Du in unserem Blogartikel HTTP-Statuscodes & ihre Bedeutung für die Suchmaschinenoptimierung.

Was ist SEO?

Mehr ausführliche Informationen zum Thema SEO

erhältst Du in unserem kostenlosen SEO-Guide.

Was sind Featured Snippets?

Featured Snippets (früher auch Position 0 genannt) erscheinen unter den bezahlten Anzeigen und noch vor den organischen Suchergebnissen. Somit nehmen sie eine sehr prominente Stelle in der SERPs ein und es ist durchaus ratsam dies in der Suchmaschinenoptimierung zu berücksichtigen. Je nach Suchanfrage können vor allem bei der informationellen Suche Featured Snippets in den Google Answer Boxen unterschiedlich ausgespielt werden. Text-Snippets, Listen oder Tabellen mit oder ohne Bild bzw. Bildern, aber auch Videos sind möglich. Da Google selbst entscheidet, welche Website im Featured Snippet ausgespielt wird, ist es für Webseiten-Betreiber nicht möglich einfach ein Featured Snippet zu erstellen oder ein solches auf ihrer Website auszuzeichnen. Dennoch ist es möglich auf Featured Snippets zu optimieren. Alles zu den Optimierungen, den Formaten und dem Einfluss auf SEO erfährst Du in unserem Blogartikel Featured Snippets: Rankings in der Google Answer Box erobern.

Was sind strukturierte Daten?

Unter strukturierten Daten kannst Du dir eine Auszeichnungsart im Quelltext einer Seite vorstellen, die Google weitere Informationen zur URL gibt. Im Gegenzug dazu kann Google Dich visuell auf den Suchergebnisseiten (SERPs) hervorheben. Wichtig hierfür ist, dass die strukturierten Daten die Suchintention Deines Besuchers widerspiegeln.

Beispiele für strukturierte Daten

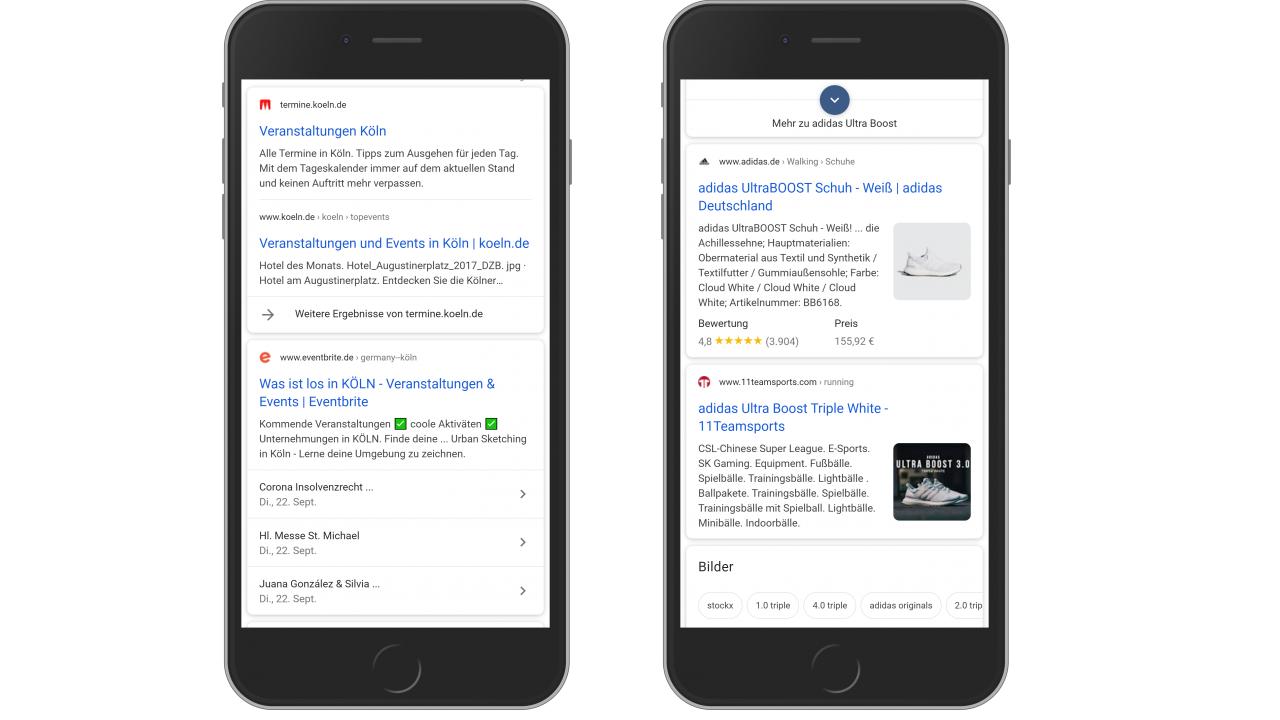

Bild 1: Auszeichnung Event mit strukturierten Daten

Bild 2: Auszeichnung Produkt mit strukturierten Daten

Wenn Du noch gar keine Kontaktpunkte mit dem Thema hast, stell Dir einfach folgendes bildlich vor: Du bist neu in der Stadt und möchtest Dir einmal ein Bild über die lokalen Veranstaltungen machen. Oder Du möchtest gerne einen bestimmten Sneaker kaufen und willst Dich zuerst darüber informieren. Was machst Du also? Du recherchierst mobil bei Google und wirst zum Beispiel folgende Ergebnisse finden:

Vorteile von strukturierten Daten

Hier siehst Du schon einen Vorteil von strukturierten Daten: Während auf dem ersten Screenshot genauere Informationen zu Veranstaltungen aufgelistet werden, findest Du auf dem zweiten Screenshot detaillierte Angaben zum Produkt (inkl. Bewertungen, Produktpreis und Lagerbestand). Für Dich als Webseitenbetreiber ist das deswegen interessant, weil Du dich schon auf den Suchergebnisseiten von der Konkurrenz unterscheiden kannst. Frage Dich selbst: Würdest Du eher auf ein Ergebnis klicken, was Dir wenig bis keine Informationen liefert oder auf ein Ergebnis, welches Dir bereits alles liefert, was Du wissen möchtest? Welche Arten von strukturierten Daten es alles so gibt, kannst Du übrigens in unserem Strukturierten Daten Guide genauer nachlesen.

Strukturierte Daten auszeichnen

Hinter derartigen Informationen stecken “strukturierte Daten”, eine Art Auszeichnung der Elemente im Quellcode. Deine Elemente müssen dafür entweder in HTML oder JavaScript (JSON-LD) umschrieben und an beliebiger Stelle im <head> oder <body> des HTML-Dokuments eingefügt werden. Je nachdem, was Du für Informationen auf deiner Seite hast (z.B. Produkte, Rezepte, Veranstaltungen, Jobs, Fragen & Antworten), gibt es andere Auszeichnungen. Bei einer größeren Seite mit vielen unterschiedlichen Seitenelementen bietet es sich zudem auch an, ein Audit für strukturierte Daten von einem technischen Ansprechpartner durchführen zu lassen.

Strukturierte Daten prüfen

Vielleicht hast Du ja bereits strukturierte Daten auf Deiner Webseite? Du kannst hier Tools wie das Testtool für strukturierte Daten verwenden und schauen, inwiefern Du schon etwas auf der Seite ausgezeichnet hast. Hier siehst Du auch, ob es Fehler oder Warnungen gibt, die Dein Ergebnis bei Google nicht visuell hervorheben. Ob Deine Seitenelemente letztendlich bei Google hervorgehoben werden, hängt von vielen Faktoren zusammen. Allen voran ist wichtig, dass Du mit den ausgezeichneten Elementen die Suchintention des Users (z.B. kaufen oder informieren) erfüllst. Es bringt also nichts, einfach was auszuzeichnen und darauf zu hoffen, dass Google es hervorhebt. Auch ist wichtig, dass sich die Elemente auch wirklich auf der Seite befinden. Google wird immer schlauer und erkennt derartige Tricks meist sehr schnell.

Pagespeed-Optimierung für schnelle Webseiten

Die Aufmerksamkeitsspanne von Nutzern digitaler Medien ist über die Jahre deutlich gesunken – Es muss alles, jederzeit und sofort verfügbar sein. Dementsprechend hoch sind die Ansprüche an schnelle Webseiten, die den Besucher nicht lange warten lassen.

Welche Auswirkungen die Ladezeit auf das Nutzerverhalten und auch den Umsatz einer Webseite hat, zeigt eine Studie von Akamai über die Auswirkung der Ladezeit auf Online Shops. Daraus geht hervor, dass eine Verzögerung von 100 Millisekunden einen Rückgang der Conversion Rate um 7% zur Folge hat.

Aus SEO-Sicht ist die Optimierung der Ladegeschwindigkeit Deiner Webseite wichtig. Im Mai 2020 stellte Google die Core Web Vitals vor, die ab 2021 als Rankingsfaktoren das Ranking Deiner Webseite in Google beeinflussen. Aus diesen beiden Gründen solltest Du also jetzt handeln.

Wie Du die Ladegeschwindigkeit Deiner Webseite deutlich verbessern und den Performance Boost zünden kannst, erfährst Du in unserem ausführlichen Artikel zur Pagespeed-Optimierung. Dabei erfährst Du, wie du die Ladezeit Deiner Webseite richtig misst, welche kostenlosen Tools Du dafür verwenden kannst und welche 5 Optimierungsmaßnahmen Du unbedingt umsetzen solltest, damit Deine Webseite richtig schnell lädt.

Sicherheit: SSL-Verschlüsselung

SSL steht für Secure Sockets Layer und ist eine Schlüsselkomponente der Web-Sicherheit. Ihr Hauptmerkmal besteht in der Verschlüsselung der elektronischen Kommunikation im Internet. Insbesondere Website-Besitzer verwenden SSL zur Verschlüsselung der Kommunikation zwischen ihrer Website (Server) und einem Benutzer (Browser). Dies geschieht durch die Anwendung von SSL auf das HTTP-Protokoll, was zum berühmten HTTPS führt.

Zusätzlich zur Sicherheit wird SSL seit 2014 von Google als Ranking-Faktor betrachtet. Infolgedessen ist der Anreiz, von HTTP auf HTTPS umzusteigen, für diejenigen, die in einer immer stärker umkämpften SEO-Landschaft bessere Rankings erzielen möchten, recht groß. Parallel dazu kündigte Google an, dass Chrome damit beginnen werde, Websites, die so genannten gemischten Content liefern, durch Blockieren ihrer HTTP-Ressourcen zu bestrafen. Daher wird es entscheidend, dass jede einzelne Webressource über HTTPS bereitgestellt wird.

Obwohl es vor einigen Jahren noch eine Herausforderung darstellte, ist die Aktivierung von SSL auf einer Website inzwischen ein recht einfacher Prozess geworden. Es genügt, ein SSL-Zertifikat auf dem Server zu installieren, auf dem die Website gehostet wird. Darüber hinaus enthalten viele Hosting-Provider inzwischen ein SSL-Zertifikat als Teil ihrer Pakete. Dies macht den Prozess der SSL-Aktivierung für Website-Besitzer, insbesondere für Nicht-Techniker, sehr viel einfacher. Die von Hosting-Providern angebotenen Zertifikate sind jedoch in der Regel mit bestimmten Einschränkungen verbunden, wie eingeschränkte Domain-Abdeckung oder geringe Validierungsanforderungen. Daher ziehen es viele Website-Eigentümer vor, ihre SSL-Zertifikate von einer Zertifizierungsstelle wie DigiCert oder Sectigo zu erwerben.

Schließlich kann SSL bei der Einhaltung von Datenschutzbestimmungen wie der DSGVO oder dem allgemeinen brasilianischen Datenschutzgesetz recht hilfreich sein. Da die Kosten für die Aktivierung oft nahe Null liegen, bleibt es eine der billigsten Maßnahmen zur Gewährleistung der Datensicherheit.

Was ist eine robots.txt? robots.txt-Datei für SEO nutzen

Ein Robots Exclusion Protocol – oder kurz robots.txt – sollte fester Bestandteil einer jeden Webseite sein, denn mit Hilfe dieser Textdatei lassen sich Crawler (Bots) einer Suchmaschine “lenken”. Die robots.txt-Datei ist ein reine Textdatei, die auf der Domain-Root (z.B. https://www.domain.de/robots.txt) angelegt wird. Hier können Seiten, Verzeichnisse oder Parameter vom Crawling ausgeschlossen werden. Webcrawler sehen sich vor dem Crawl diese Datei an und erhalten Hinweise auf mögliche ausgeschlossene Seiten. Auch ein Link zur XML Sitemap kann in dieser Datei hinterlegt werden. Damit in der Anwendung keine wichtigen Seiten ausgeschlossen werden oder sensible Inhalte zugänglich gemacht werden, solltest Du die robots.txt-Datei mit Bedacht nutzen. Das ist vor allem auch für die Suchmaschinenoptimierung sehr wichtig, um den Crawlern zu allen relevanten Seiten Zugang zu gewähren, denn nur so können Seiten in den Index aufgenommen und auf Suchergebnisseiten ausgespielt werden.

Einen ausführlichen Einblick in die Anwendung und den Aufbau der robots.txt-Datei erhältst Du in unserem Blogartikel zum Thema robots.txt Blogartikel zum Thema robots.txt. Hier erfährst Du auch einiges zu den unterschiedlichen User-Agents und wie Du die robots.txt-Datei über die Google Search Console überprüfen kannst.